di Francesco Rundo, A. Luigi Di Stallo

Recenti statistiche hanno confermato che Il problema legato al cattivo funzionamento della giustizia in Italia, è tra i temi piu’ dibattuti, tanto da essere quotidianamente menzionato sulla stampa nazionale. La lungaggine dei processi sia in sede civile che penale è certamente, tra tutti, il problema che maggiormente penalizza (e paralizza) il sistema giuridico italiano. Numerose riforme di legge, negli anni passati, hanno tentato di ridurre questo “gap”, senza però produrre sostanziali miglioramenti nel timing dei tempi medi che oggi un cittadino deve attendere prima di vedere un procedimento giudiziario che lo riguarda, giungere a conclusione. Peraltro le (lunghissime) attese lungi dal ridursi si replicano invece nell’ambito di ciascun grado di giudizio! L’articolo che gli autori intendono proporre in questa sede si pone l’ambizioso quanto arduo obiettivo di ipotizzare una possibile soluzione per migliorare il sistema processuale italiano, nello specifico, la durata media di un procedimento giudiziario. Segnatamente, gli autori rappresenteranno i potenziali effetti sul sistema giustizia di un motore di Deep Learning (Intelligenza artificiale) addestrato ad analizzare il testo delle sentenze emesse da uno specifico Tribunale in riferimento ad un determinato argomento. Si anticipa sin d’ora che il motore algoritmico sarà – quale esito finale – in grado di fornire una stima predittiva ex-ante di probabile vittoria/soccombenza in giudizio, ogni qual volta un suo fruitore vorrà valutare preliminarmente l’esigenza di istruire una causa in un determinato foro ed in riferimento ad una specifica materia. In particolare, gli autori intendono illustrare – quale esempio qualificato – una applicazione pratica di questi motori algoritmici al settore del contenzioso bancario-finanziario.

1. Introduzione

Da tempo si dibatte sul tema della “giustizia predittiva” tramite l’uso di algoritmi di Deep Learning o intelligenza artificiale. Per “giustizia predittiva” deve intendersi nell’accezione utilizzata dagli autori la possibilità di prevedere l’esito di un giudizio tramite algoritmi matematici, ovvero di prevedere le chance di soccombenza/vittoria relativa ad una specifica questione di fatto e/o di diritto controversa. In molti altri ambiti delle scienze l’utilizzo dell’intelligenza artificiale è già una realtà, dunque è corretto domandarsi se in ambito processuale la “giustizia predittiva”, alla luce delle nuove possibilità tecniche, possa ancora considerarsi una ipotesi futuristica, quanto piuttosto ad un argomento attuale. Punto fermo di ogni ragionamento sulla “giustizia predittiva” è certamente il principio del giusto processo (art.111 Cost. ; art. 6 CEDU) che applicato all’ambito di cui si discute, dovrebbe suggerire l’adozione di algoritmi che siano in grado di riprodurre autonomamente tutti gli elementi che contribuiscono a rendere un procedimento giudiziario equo e giusto, come ad esempio, l’indispensabile diritto al “contraddittorio”. La giurisprudenza italiana, in rare pronunce e seppur indirettamente, ha affrontato il problema dell’utilizzo dell’intelligenza artificiale nel processo giudiziario. Ci riferiamo alla nota sentenza del Consiglio di Stato (la prima si ritiene) che ha affrontato la questione del diritto di “accesso” delle parti interessate all’algoritmo (Consiglio di Stato, sez. VI, sentenza 8 aprile 2019, n. 2270). In estrema sintesi, i giudici hanno affermato che il collegio giudicante può indagare sulla “…correttezza del processo automatizzato in tutte le sue componenti”. Come anticipato in premessa, la questione dei “tempi della giustizia” è presenti nel dibattito politico/parlamentare, praticamente senza soluzione di continuità. Tutti concordano sulla inadeguatezza dei tempi di risposta rispetto alla domanda di giustizia, richiamando a vario titolo una pacifica violazione del richiamato articolo 111 della Costituzione e dell’articolo 6 Convenzione Europea dei Diritti dell’Uomo (CEDU). Un criterio oggettivo spesso utilizzato per misurare la lungaggine dei processi giudiziari in Italia (sia in ambito civile che penale ed amministrativo) è quello del tasso di resistenza/istruttoria riferito agli altri gradi di giudizio, rispetto al primo. Va detto tuttavia che nonostante la rilevata percentuale di conferma e/o di resistenza di una decisione nei successivi gradi di giudizio, molti procedimenti potrebbero essere del tutto evitati, con notevole beneficio per il sistema giudiziario, nell’ipotesi in cui si riuscisse ad avere a disposizione strumenti tecnici affidabili atti a rendere prevedibili le concrete chance di successo/soccombenza, ovvero nell’ipotesi di gravami di conferma o meno della sentenza.

In questo specifico quadro di riferimento va inquadrato ai nostri fini il concetto della “prevedibilità della sentenza”. Il sistema giudiziario italiano può contare su una rilevante quantità di banche dati giurisprudenziali. Si cita, a titolo di esempio, il Centro elettronico di documentazione (CED) della Corte Suprema di Cassazione che contiene archivi, mediante i quali è possibile effettuare un’ampia ed esaustiva ricerca, oltre che giurisprudenziale, anche legislativa e dottrinale. A questa si associano le numerose banche dati software che consentono di ottenere in formato elettronico, le sentenze emesse nelle corti di merito raggruppate per foro, per giudice, per settore, etc.. Dalla consultazione delle banche dati relative alla giurisprudenza di merito e di legittimità, sarà quindi possibile ricavare informazioni sui processi motivazionali/decisionali. Sarà inoltre possibile avere altre informazioni, ad esempio, sull’attività del singolo giudice, sul livello di resistenza e accoglimento dei relativi provvedimenti, più in generale sulla eventuale omogeneità/non omogeneità degli orientamenti giurisprudenziali del tribunale e/o di quella determinata sezione specializzata ed infine –tema centrale di questo articolo- dati per caratterizzare un modello algoritmico in grado di fornire all’utente elementi utili a valutare la probabilità di accoglimento della questione giudiziaria che si sta istruendo.

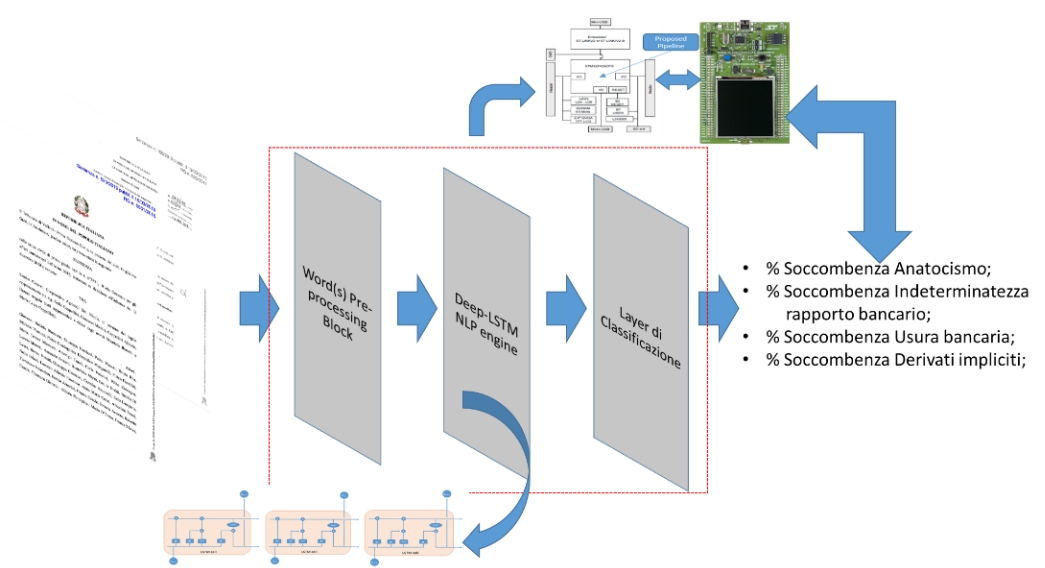

E’ indubbio, almeno in tesi, che la possibilità di avvalersi da parte degli operatori di giustizia (in primo luogo per gli avvocati) dell’ausilio di strumenti predittivi affidabili, può contribuire all’utilizzo/suggerimento di strategie alternative da consigliare agli utenti finali che alla giustizia intendono rivolgersi, con un potenziale effetto positivo sull’economia processuale dell’intero sistema giudiziario. A livello europeo, altre nazioni si stanno già adoperando nel settore della “giustizia predittiva”. Ad esempio, in Francia è stata creata la piattaforma Predictice, la quale consente di stimare il probabile esito giudiziario di un contenzioso [1]. Il relativo modello statistico-inferenziale è incentrato su una base-dati costituita da sentenze ottenute in diversi gradi di giudizio. In altri paesi si parla addirittura del c.d. “giudice robot” in grado di velocizzare, uniformare e automatizzare le decisioni giudiziarie in ambito civile. In Italia, alla luce del riferito contesto, appare utile ipotizzare la progettazione ed implementazione di una “piattaforma intelligente” che , in piena armonia con i principi etico-normativi richiamati, sia in grado di suggerire al cittadino che intende istruire un procedimento giudiziario, piuttosto che all’avvocato, se possa o meno risultare utile dirimere una determinata questione mediante ricorso al processo. A tal fine gli autori propongono l’utilizzo una pipeline di c.d. text-processing and mining, basata su un motore NLP (Natural Language Processing), implementato con dei sistemi basati su Deep Learning, precisamente mediante reti LSTM (Long Short Term Memory) con un layer neuronale di classificazione [2]-[3]. Il sistema proposto, partendo dall’analisi automatica del testo delle sentenze emesse da un determinato foro e in riferimento ad una specifica tematica, classificherà opportunamente l’esito della sentenza, generando una percentuale di soccombenza in relazione alle questioni oggetto della domanda giudiziaria.

2. Il sistema NLP per l’analisi automatica delle sentenza e la stima del rischio soccombenza

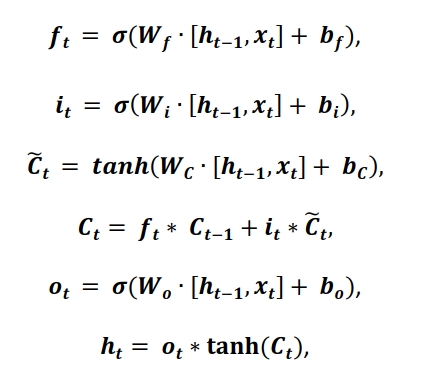

Generalizzando il concetto (non distingueremo per semplificare tra giudizio di merito e di legittimità), una sentenza può dirsi costituita da un testo contenente il personale convincimento del giudice/collegio giudicante in relazione all’oggetto del contendere, quest’ultimo basato sulla narrazione (e contestuale produzione di prove) dei fatti ad opera delle parti e sulla esposizione delle questioni di diritto richiamate. In tale contesto, un sistema di giustizia predittiva dovrà basarsi sull’analisi semantica del testo di numerose sentenze, opportunamente classificate per argomento e giudice/foro, cercando di estrarre le informazioni che caratterizzano il convincimento del/dei giudicanti sulla questione di fatto e/o di diritto trattata e, da questa base informativa, dovrà essere in grado di stimare le probabilità di soccombenza/vittoria in riferimento ad una specifica domanda che si intende (eventualmente) incardinare in quel determinato foro. Dunque, ai fini dell’analisi, oltre alla predisposizione di un algoritmo, risulta fondamentale la scelta di un data-set che sia statisticamente significativo. Per tale scopo, nell’ambito del deep learning sono stati studiati I c.d. “motori NLP”. Si tenterà ora di rappresentare sinteticamente l’iter logico-analitico che seguono questi algoritmi e poi il data-set di riferimento, utile a proporre la pipeline di giustizia predittiva ivi descritta. I dati di un qualsiasi testo, sono naturalmente sequenziali. Un testo può essere rappresentato come una sequenza di parole, che potrebbero avere o meno una dipendenza. Per rilevare le (eventuali) dipendenze presenti in un testo e per classificare i dati testuali in sequenza, si propone l’utilizzo di reti LSTM, che avendo una struttura neurale ricorrente, sono in grado di apprendere dipendenze a lungo termine.

Preliminarmente, sarà eseguita una conversione dei dati di testo in sequenze numeriche [3]. È possibile ottenere ciò utilizzando una codifica (encoding) di parole che associano le frasi a sequenze di indici numerici opportunamente determinati. Per risultati migliori, è necessario creare un “dizionario” di vettori numerici, anziché di indici scalari al fine di apprendere dettagli semantici delle parole, in modo tale da generare vettori numerici simili per testi che hanno parole differenti ma significati simili. Per mostrare “le abilità” del metodo proposto, abbiamo eseguito dei test analizzando il testo di sentenze emesse da alcuni tribunali del territorio nazionale, che per ragioni di ovvia riservatezza, non saranno palesate nel presente documento. Gli autori hanno analizzato sentenze di primo grado, riferite alla materia del contenzioso bancario. Nello specifico, trattasi di sentenze riferite a contratti bancari (conti correnti, mutui ipotecari e fondiari, prestiti chirografari, aperture di credito in conto corrente, etc…). Per questo genere di contenziosi, i profili giuridici posti alla base della domanda sono prevalentemente i seguenti:

Anatocismo. Detta pratica implica, in estrema sintesi per la sua verifica, il calcolo dell’ammontare degli interessi via via maturati su un montante composto dal capitale prestato e dagli interessi già pagati sino a quel momento. In ambito finanziario, ciò si traduce nell’applicare un regime di interesse composto che è regolamentato da precise norme di legge (art. 1283 c.c. ; D.lgvo 385/93 (Testo Unico Bancario) e dalla delibera CICR del 09.02.2000 s.m.i. oltre che dalle direttive emesse dall’organo di vigilanza (Banca di Italia) agli intermediari bancari e finanziari). Ebbene, sul tale tema, esistono moltissime pronunce fortemente discordanti;

Determinatezza e determinabilità delle clausole contrattuali in un contratto bancario. La legge prescrive precise norme circa l’univoca e uniforme determinatezza /determinabilità dei parametri che caratterizzano i contratti bancari onerosi (si veda ad esempio l’ex art. 1284, 1346 c.c.; ex art. 117 comma 4-6 TUB in relazione al tasso di interesse). Su questo tema, esistono numerose pronunce giudiziarie divergenti delle varie corti di merito ingenerando, anche in questo caso, una forte disomogeneità;

Usura bancaria. Su questo tema, probabilmente, si concentra la maggior parte del dibattito giuridico italiano relativo al contenzioso bancario con sentenze spesso in aperto contrasto , generando ulteriore confusione in un quadro già particolarmente “caotico”. La normativa di riferimento è, almeno in apparenza, piuttosto chiara (L. 108/96 ; L. 24/2011; ex art. 1815 c.c.; ex art. 644 cp) mentre l’esecuzione analitica del calcolo del tasso di interesse complessivo del rapporto bancario da raffrontare con il tasso massimo consentito dalla legge è – sovente- oggetto di dibattiti (anche piuttosto animati) tra tecnici, matematici ed economisti specificamente, ad esempio, agli oneri finanziari da includere o meno nel calcolo del tasso, sul modello da adottare, sulla modalita’ di risoluzione analitica del modello matematico, etc…

Derivati impliciti. Anche su questo tema, sebbene con minor intensità, vige un discreto dibattito giurisprudenziale. Nello specifico, si dibatte se configurare o meno come “derivato implicito” la presenza o meno di certe clausole sui contratti bancari (clausole CAP, FLOOR etc..).

Ebbene, per ciascuno dei profili sopra citati, prima di istruire un contenzioso bancario in un determinato foro, potrebbe essere valutata l’opportunità di comprendere in anticipo quali sono le chance di vittoria (e dunque di soccombenza), determinabili dallo studio delle precedenti pronunce emesse dal foro di riferimento, sui medesimi profili. La figura che segue mostra la pipeline proposta nel presente contributo:

Le seguenti equazioni caratterizzano la singola cella della rete LSTM utilizzata nel nostro motore NLP:

Gli autori propongono l’adozione del framework software/hardware STM32 con supporto AI [4] per la realizzazione di un sistema embedded portatile in dotazione ad ogni operatore di settore, tale da consentire in ogni momento di accedere alle banche dati giuridiche e di analizzare, in tempi ridotti, l’orientamento di un determinato giudice/tribunale su un determinato argomento. Per l’apprendimento del sistema, gli autori hanno selezionato alcuni dei fori dove statisticamente si istruiscono più contenziosi nel settore bancario e finanziario. Sono state recuperate le sentenze mediante una banca dati (GiustUp) [5]. Per ciascun tribunale, si sono esaminate le principali sentenze emesse negli ultimi anni ed in relazione al settore bancario. Circa il 70 % di queste sono state usate per il Learning del sistema, mentre il restante 30 % per la validazione. Ebbene, con una accuratezza media del 91,25 % circa, la pipeline prodotta è stata in grado di definire correttamente le chance di soccombenza per ciascuna pretesa avanzata in via giudiziaria.

3. Conclusioni

La pipeline algoritimica descritta nel presente lavoro dimostra le potenzialità derivanti dall’applicazione del deep learning nell’ambito delle scienze giuridiche e, segnatamente nel fornire soluzioni utili a prevedere gli esiti giudiziari e dunque in generale potenzialmente in grado di migliorare il sistema giudiziario nazionale. Tuttavia, il tema della giustizia predittiva richiede certamente ulteriori approfondimenti, sia in relazione alle questioni etico-normative che in riferimento alle questioni tecnico-implementative. ©

BIBLIOGRAFIA

1 https://predictice.com/

2 Sepp Hochreiter; Jürgen Schmidhuber (1997). “Long short-term memory”. Neural Computation. 9 (8): 1735–1780.

3 Graves, A.; Liwicki, M.; Fernandez, S.; Bertolami, R.; Bunke, H.; Schmidhuber, J. (2009). “A Novel Connectionist System for Improved Unconstrained Handwriting Recognition” (PDF). IEEE Transactions PAMI. 31 (5): 855–868. CiteSeerX 10.1.1.139.4502.

4 https://www.st.com/content/st_com/en/about/innovation—technology/artificial-intelligence.html

5 http://www.giustup.it/